Concentração de Medida

Este é um post meio maluco, porque é absolutamente específico a coisas de machine learning e não é nem de perto uma aplicação prática. Mas é um tópico que é muito interessante e que eu acho que é bastante acessível.

Vamos começar com um velho conhecido, a desigualdade de Chebyschev:

Nós todos conhecemos essa desigualdade, que é usada como uma maneira de “provar” que a média amostral é um estimador consistente: a variância da média de um processo i.i.d. com variância é e portanto Chebyschev nos dá:

Então quando , está próximo de . A Desigualdade de Chebyschev é uma aplicação de um resultado mais elementar, a desigualdade de Markov, que diz que para qualquer variável aleatória positiva:

Se você trabalhar com e , você chega na desigualdade de Chebyschev.

Existem outras maneiras de deixar uma variável positiva, e uma bacana é usando . Eu vou assumir média zero e trabalhar com e :

Agora, alguns de vocês sabem, mas apenas para garantir: é conhecido como a função geratriz de momentos. Nem todas as distribuições tem função geratriz de momentos. A parte bacana é que as derivadas com respeito a da função geratriz de momentos (avaliada em ) nos dão os momentos da distribuição. Por exemplo, a normal com média e variância tem como função geratriz de momentos . Tire as derivadas e avalie em para se convencer de que o que eu disse é verdade.

Sabendo disso, nós podemos dizer que se é Normal com média zero e variância , então a desigualdade que eu coloquei com exponencial implica:

Isso é verdade para qualquer . A gente pode escolher o que minimiza o valor na desigualdade, via as condições de primeira ordem, que nos dão:

Onde eu usei que é monotônico e portanto não altera o ponto do máximo. Devolvendo isso para a desigualdade nós temos:

Essa desigualdade também tem um nome: Desigualdade de Chernoff (pra ser honesto: tudo que eu li disso é em inglês. Em inglês chamam de Chernoff Bound, mas eu traduzi para desigualdade já que temos a desigualdade de Chebyschev)

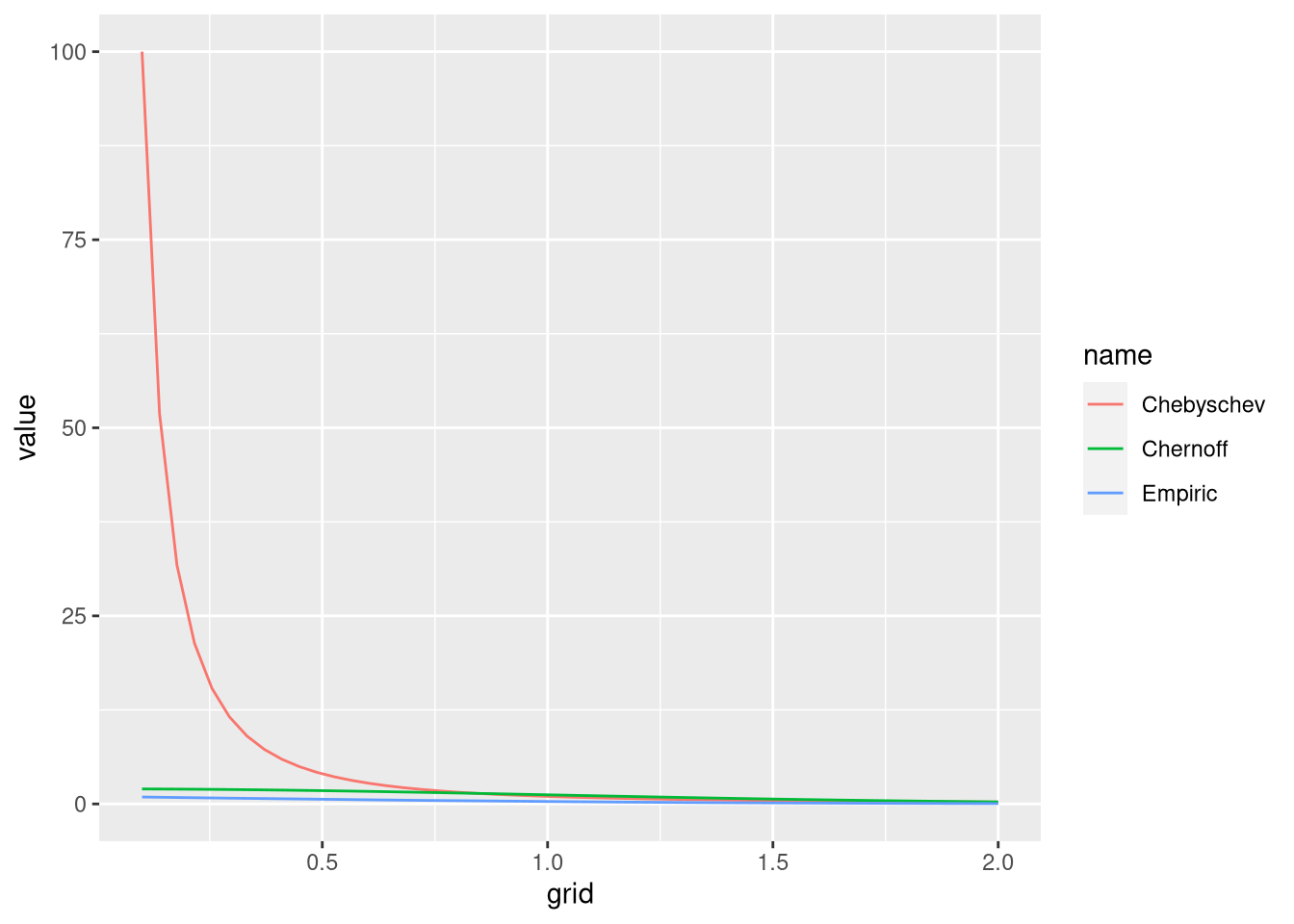

Deixa eu convencer vocês que isso é bem legal: eu vou simular 10 mil sorteios da normal padrão e comparar o que cada uma dessas desigualdades significa. Eu vou contar a probabilidade de ser maior que simplesmente computando a frequência em que os valores simulados são maiores que para um grid de valores . Eu também vou trabalhar com o valor absoluto de :

Veja que eu fiz um hardcode de que a variância é 1. Fica bem claro que:

As duas desigualdades fazem o que prometem: elas estão sempre acima na probabilidade verdadeira

Chebyschev distorce totalmente o gráfico porque é extremamente generosa

Vamos eliminar Chebyschev do gráfico:

Veja que essa cota é bem generosa, mas bem melhor que a desigualdade de Chebyschev. Obviamente, pagamos um preço por isso: nem todas as funções com variância finita tem função geratriz de momentos.

Um fato mais interessante é que você pode usar a desigualdade de Chernoff, exatamente como posta acima, para outras distribuições além da gaussiana. Basicamente, você está exigindo que a cauda da distribuição caia tão rápido quanto a gaussiana. Distribuições que atendem a esse requisito são chamadas de subgaussianas. Todas as distribuições com suporte finito atendem a esse pré requisito, por exemplo. Por sinal, no caso mais geral não precisa ser a variância da distribuição. Nem todas as distribuições são subgaussianas: a qui-quadrado não é sub gaussiana, e é uma distribuição extremamente comum em estatística.

Veja que essa cota depende exponencialmente de , ao contrário de Chebyschev que depende de . Isso é um ganho dramático: com altíssima probabilidade a massa da distribuição está concentrada. Além de ser bem bacana, isto aparece em várias situações em machine learning. Mas eu não consegui criar nenhum exemplo simples em que isso fique evidente, então fica pro próximo post.