Erros padrões HAC

Provavelmente vocês já se depararam com a situação de que você precisa usar erros que corrigem para o fato do erro ser possivelmente autocorrelacionados ou heterocedásticos. Enquanto a parte de heterocedasticidade é bastante interessante, esse post vai focar no problema de erros consistentes para processos correlacionados.

Para começar, suponha que temos um processo estocástico que é autocorrelacionado. Suponha que queremos calcular a média do processo, então teremos . Agora, qual a variância da média? No caso iid, nós faríamos:

Eu impunemente passei o somatório para fora da variância porque o processo é iid. Se tiver autocorrelação, nós vamos ter de considerar as covariâncias:

Veja que eu estou trabalhando com processos estacionários, e isso me permite dizer que etc.

Que teremos T covariâncias parece simples, mas como eu sei que teremos T-1 covariâncias entre dois períodos sequenciais? Veja que como a amostra está limitada até T, todos os períodos menos o T tem um vizinho seguinte: portanto T-1 covariâncias seguintes. Já para , tanto o período quanto o período não tem vizinhos para frente: logo temos . Etc etc. Isso exige uma certa imaginação, eu admito.

O mais incrível é que nós também temos que considerar as covariâncias para trás, ou seja , etc. Felizmente, graças ao fato de o processo ser estacionário de segunda ordem, temos que e portanto:

Ou seja, a variância da média de depende da soma das covariâncias do processo. Antes de prosseguirmos, só um pequeno detour. Para deixar a notação menos carregada, faça , ,…, , e a expressão acima pode ser reescrita como:

Reescale tudo por , que é o equivalente a multiplicar o somatório por , como a gente faria para aplicar o teorema central do limite, para obter:

Logo a variância assintótica ($T ) depende do somatório das auto-covariâncias - e das covariâncias daqui até o infinito! Obviamente, nós não temos nenhuma chance de conseguir isso.

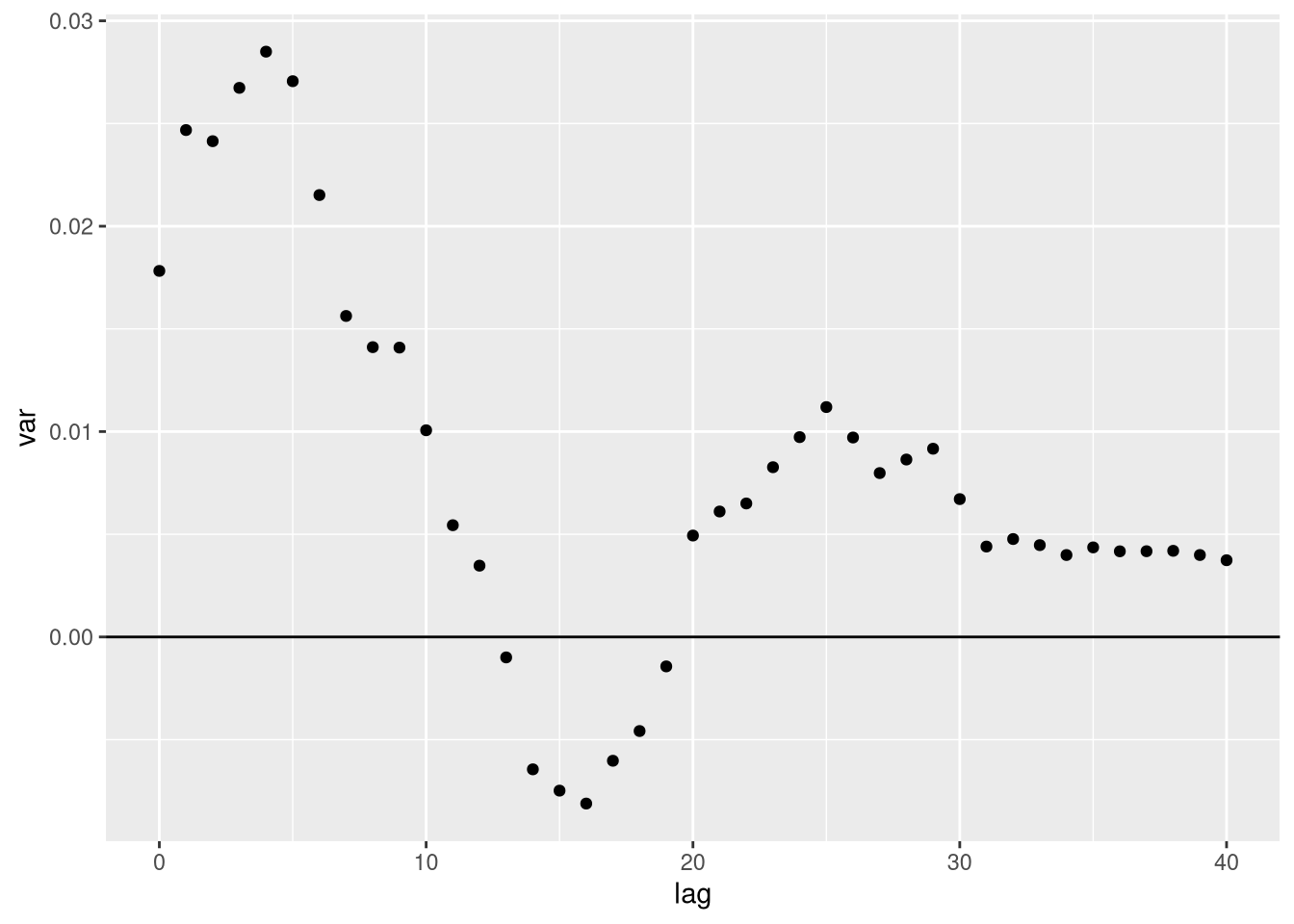

Isso gera também o seguinte problema: podemos ter auto-covariâncias negativas (um ar(1) com parâmetro negativo vai gerar autocorrelações pares que são positivas mas ímpares negativas). Usando a autocovariância amostral, podemos ter isso. Por exemplo, vamos trabalhar com um AR(1) com parâmetro 0.5 e a inovação tem variância 1. Eu vou usar 50 observações. Veja que se truncassemos entre os lags 10 e 20, teríamos uma variância negativa:

Obviamente, variâncias não são negativas. Nossa amostra só permite calcular até a autocovariância , e com precisão cada vez pior (a autocovariância em T só tem uma observação, enquanto a autocovariância de um lag tem T-1 observações). Nós precisamos garantir que a variância vai ser positiva.

A variância calculada usando HAC faz isso dando pesos de maneira esperta para cada autocovariância: eles envolvem argumentos de estatística não paramétrica e por isso eu não vou entrar em detalhes. Existem várias possibilidades de Kernel, e Kernel exige a seleção de um parâmetro de bandwidth.

Veja que no caso de erros robustos apenas a heterocedasticidade, esse tipo de argumento não precisa ser aplicado: o problema é que em processos de série temporal os erros vão estar correlacionados. Usar matrizes robustas a heterocedasticidade apenas não envolvem argumentos de métodos estatísticos não paramétrico.

Em geral nós usamos erro padrão HAC para testar uma hipótese em regressão em que podemos ter erros autocorrelacionados. Quando fazemos testes a 5%, nós estamos controlando a probabilidade de cometer um erro do tipo I (i.e. rejeitar a hipótese nula quando ela é verdadeira) de no máximo 5%. Mais que isso é sinal que nosso teste tem algum problema. Para ilustrar isso, eu vou fazer algumas simulações monte carlo (como de praxe).

Para ficar fácil, eu vou trabalhar com uma regressão com um único coeficiente, que vai ser zero, sempre. Vão mudar o tamanho da amostra e o processo gerador de dados. Eu vou sempre testar 3 maneiras: ignorando o problema, usando o padrão do pacote sandwhich (que é o sugerido pelo Andrews), e a primeira HAC sugerida, o Newey-West.

Para começar, vamos testar o caso em que nós somos meramente preguiçosos e colocamos erros robustos a autocorrelação sem pensar muito no tema:

| x | |

|---|---|

| Sem correção | 0.0553333 |

| HAC Default | 0.0666667 |

| Newey West | 0.0870000 |

Ser preguiçoso é problemático: nós rejeitamos quase 1% a mais do que os 5% que queremos alcançar ao usar o padrão do pacote - e se usarmos a proposta do Newey West, a situação é ainda pior. Agora, vamos colocar erros auto regressivos:

| x | |

|---|---|

| Sem correção | 0.0536667 |

| HAC Default | 0.0656667 |

| Newey West | 0.0803333 |

Newey-West é desastroso, com um tamanho de 8%. Ignorar o problema parece, estranhamente, a melhor estratégia! Vamos aumentar a persistência do erro colocando o parâmetro auto regressivo em 0.95 e aumentar o número de observações, o que vai ajudar na convergência dos estimadores HAC:

| x | |

|---|---|

| Sem correção | 0.0506667 |

| HAC Default | 0.0530000 |

| Newey West | 0.0516667 |

Mais um caso, com erro seguindo um MA:

| x | |

|---|---|

| Sem correção | 0.0476667 |

| HAC Default | 0.0526667 |

| Newey West | 0.0703333 |

Vamos aumentar o número de observações para mil:

| x | |

|---|---|

| Sem correção | 0.0453333 |

| HAC Default | 0.0456667 |

| Newey West | 0.0456667 |

Veja que de maneira geral, os testes no caso de erros autocorrelacionados tem problemas de tamanho. Newey West gera resultados preocupantes - no nosso primeiro e segundo exemplo, a porcentagem de erros tipo I foi 8% quando estavamos usando o teste para obter um erro de tipo I em 5% dos testes. Ignorar o problema não parece uma boa estratégia, apesar de os resultados serem razoáveis em muitos casos. Eu fiz só alguns exemplos muito simples e isso pode gerar resultados que parecem bons. O padrão do sandwich nos dá resultados razoáveis para quase todos os DGPs.

Veja que os efeitos no mundo real disso são bem simples: nós rejeitamos a hipótese nula com frequência diferente da que estamos controlando.

Bibliografia

Como de praxe, o blog é minha tentativa de transmitir para um outro público coisas que eu aprendi com excelentes professores. O curso do Mark Watson e do Jim Stock no NBER em 2008 é uma excelente fonte. O livro do Hamilton de Time Series é uma fonte padrão.