Concentração do Máximo

Este post é uma continuação do post sobre concentração de medida, e vai ser necessário para um post futuro.

Naquele post eu falei sobre variáveis subgaussianas, para as quais a seguinte desigualdade vale:

Agora suponha que você tem uma coleção de variáveis aleatórias, todas subgaussianas e não necessariamente independentes. Neste post, nós vamos cotar a probabilidade do máximo delas ser maior que um valor t.

Se você precisa de uma motivação pra isso, eu ofereço duas:

- Nós frequentemente trabalhamos com estimadores que minimizam ou maximizam alguma função: mínimos quadrados, máxima verossimelhança. É natural que estes estimadores dependam do máximo de uma variável aleatória

- Se você está trabalhando com algum processo aleatório, muitas vezes o máximo pode ser mortal: qual é o máximo que um ativo pode perder se a distribuição dos retornos é subgaussiana, por exemplo?

O próximo post vai ilustrar uma aplicação dessas desigualdades no caso 1. Para o problema em mãos, nós queremos:

A primeira observação é que se o máximo de uma coleção é maior que , então pelo menos um dos elementos da coleção é maior que (duhhh). Logo, o problema é equivalente ao problema “pelo menos um dos é maior que t”. A gente vai escrever isso como .

Qual a vantagem disso? Bom, a seguinte desigualdade vale:

Eu não vou dar uma prova extremamente formal: se e são dijuntos - se acontece, então nunca acontece - então . Isso pode ser estendido pra qualquer união finita de conjuntos. Suponha o caso mais geral, em que e não são dijuntos. Eu posso escrever:

O superescrito significa o evento complementar. Pelo resto do post, vai representar . Veja que é dijunto de e os dois são dijuntos de . Logo, eu escrevi a união de dois conjuntos como a união de dijuntos. Então:

Agora, nós podemos escrever (A é a união de A interseção B e A interseção não B). Usando o único resultado que nós temos sobre probabilidade:

Eu posso fazer a mesma coisa com , e nós temos:

Agora, probabilidades são sempre não negativas, então:

A nossa desigualdade é só é uma generalização para mais dois eventos.

De volta ao fio da meada, suponha que nós temos uma coleção de variáveis subgaussianas, todas com parâmetro . Usando o meu argumento:

Agora, use a cota para uma variável subgaussiana:

Vamos deixar isso mais bonitinho: Faça . Então:

Se , então . Considere os termos de t: é positivo e é sempre positivo, então:

Multiplicando por a gente inverte a desigualdade, logo:

Na última igualdade, eu usei que

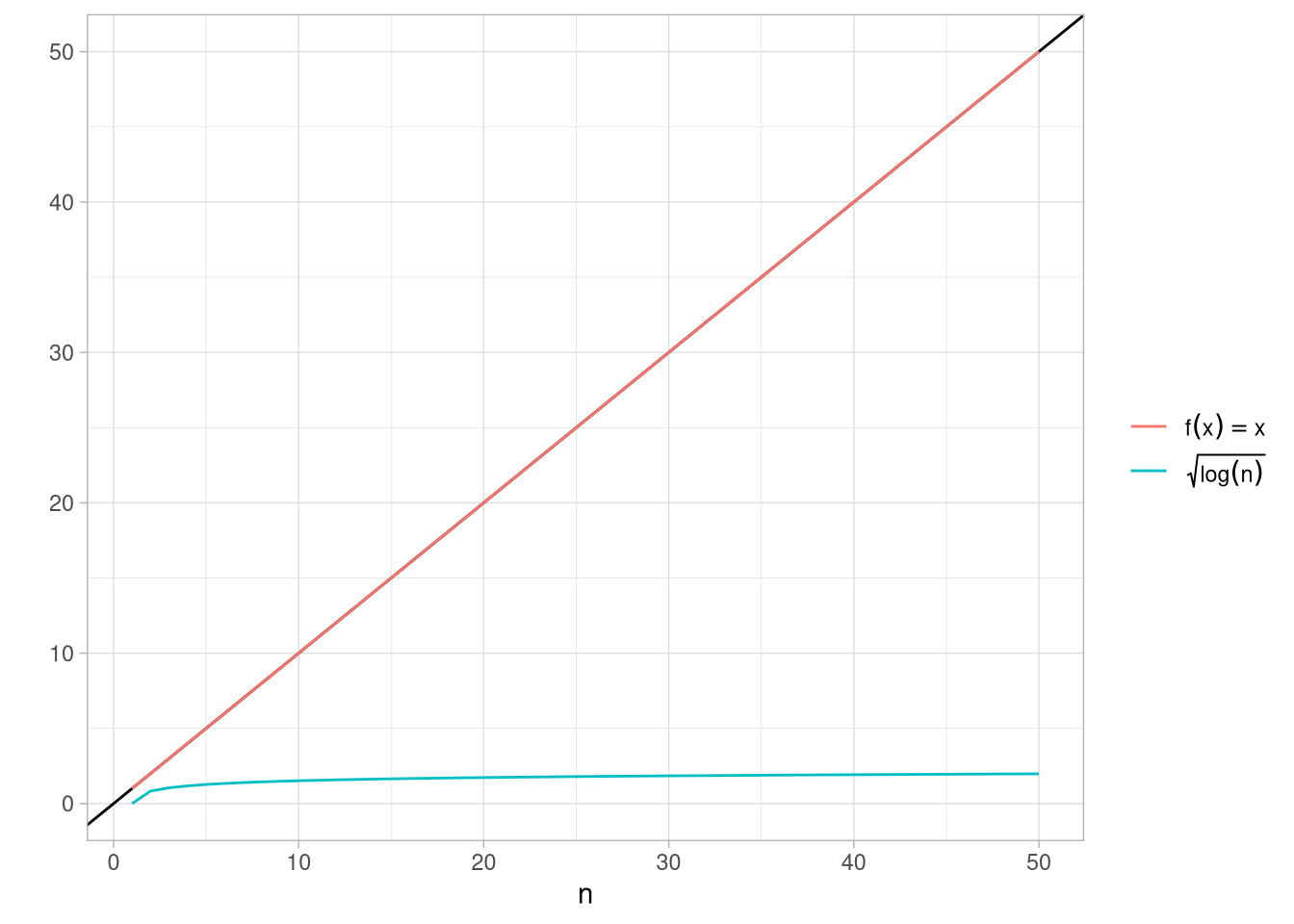

O que essas contas todas dizem? Primeiro, mesmo se todas as variáveis tem média zero, o máximo delas não vai estar centrado em zero: a gente ganhou um termo . Esse termo é extremamente benevolente: ele cresce a raiz quadrada do log de n. Isso é bastante lento, como a figura abaixo mostra:

A segunda observação é que as chances do valor do máximo ser muito maior que é muito baixo: a cauda cai com a exponencial do quadrado, ou seja, a mesma velocidade da gaussiana.

Este post é estupidamente abstrato, mas ele vai ser necessário para um post no futuro que é um pouco menos abstrato.